Smart Data Management

Optimieren Sie Ihren digitalen Arbeitsplatz durch intelligentes Datenmanagement

Inhaltsverzeichnis

In Zeiten von immer komplexeren Datenströmen und Big Data Anwendungen sind die zu verwaltende Datenmenge und deren Speicherort für Unternehmen von großer Bedeutung. Jedoch spielt für ein professionelles Data Management auch die Art der Daten eine besondere Rolle: Welche Informationen liegen vor? Wie sensibel sind diese Daten? Für welchen Zweck werden sie benötigt? Und wie lassen sie sich für bestimmte Situationen verfügbar machen?

Angesichts der zunehmenden Digitalisierung des Arbeitsplatzes muss der Zugriff auf relevante Daten auch von Zuhause, auf Reisen oder von verschiedenen Niederlassungen aus möglich sein – zum Beispiel für eine standortübergreifende digitale Teamarbeit. Archivierung und File Sharing sind deshalb zwei entscheidende Themen im Unternehmensalltag und die Voraussetzung für erfolgreiches Dokumentenmanagement.

Professionelles Data Management durch Data Analytics und Data Governance

Mit einer professionellen Data Management Plattform holen Sie sich eine effiziente Lösung für das Management strukturierter und unstrukturierter Daten in Ihr Unternehmen und maximieren das Nutzungspotenzial großer Datenmengen.

Mithilfe von Data Analytics (Datenanalyse) lassen sich Daten aus unterschiedlichen Quellen erheben und untersuchen, um relevante Zusammenhänge herzustellen. Durch die Auswertung von Big Data schaffen Sie die Basis für starke Wettbewerbsvorteile gegenüber Ihrer Konkurrenz.

Durch Data Governance (Stammdaten-Management) profitieren Sie von einer hohen Datenqualität – durch das zuverlässige Management der Verfügbarkeit, Integrität, Benutzerfreundlichkeit und Sicherheit Ihrer Unternehmensdaten. Zum einen erkennen und vermeiden Sie dadurch leichter Risiken, zum anderen nutzen Sie Unternehmenspotentiale effizienter und reduzieren Ihre Kosten.

Damit steht der Verwaltung und kollaborativen Nutzung Ihrer Daten nichts mehr im Weg. Als IT-Systemhaus unterstützen wir unsere Kunden seit langer Zeit erfolgreich in den folgenden Bereichen:

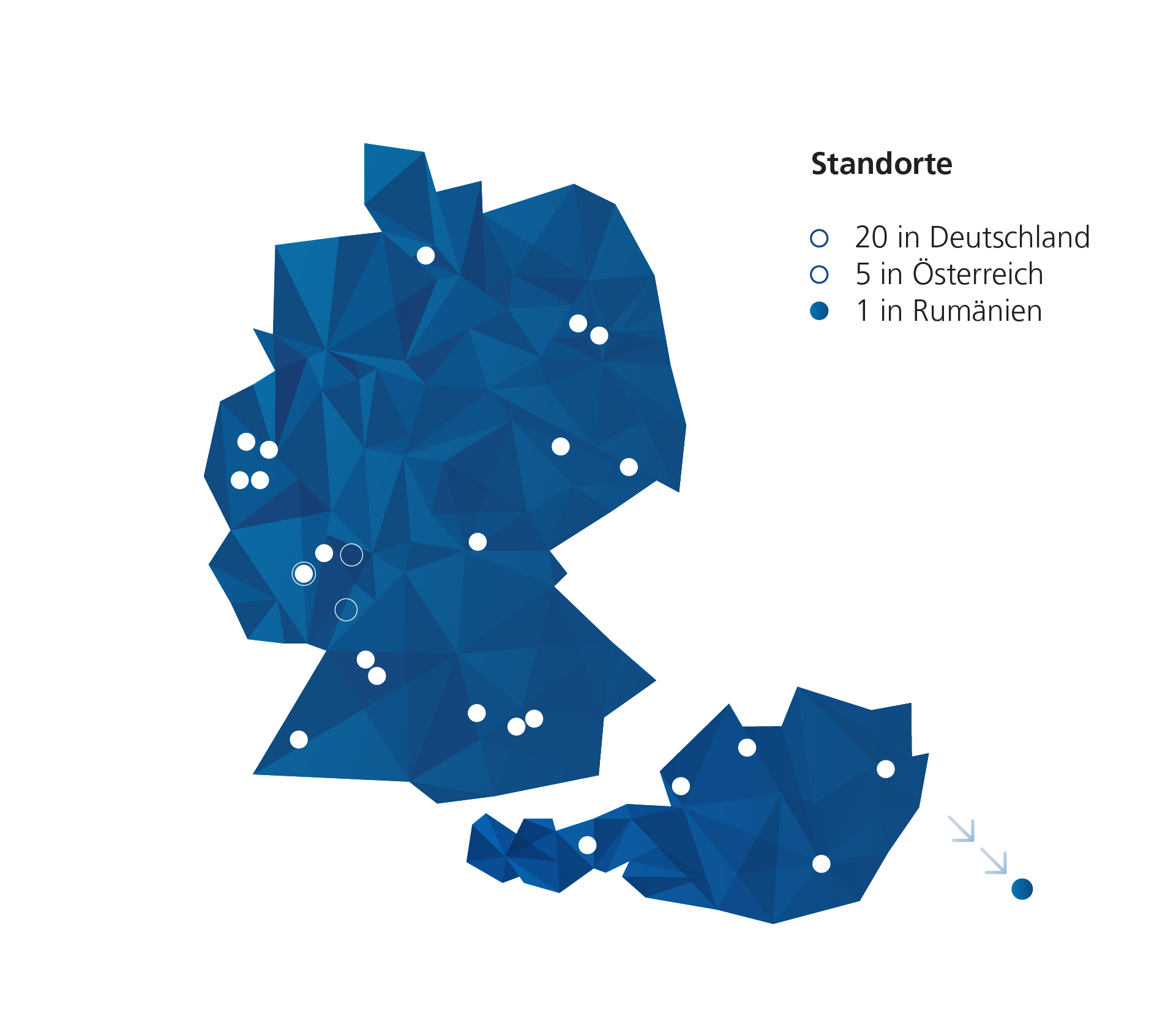

Medialine AG: Ihr Partner für Data Management Platforms

Nutzen Sie die Vorteile von effizientem Datenmanagement und optimieren Sie die Zusammenarbeit Ihrer Teams: Wir beraten Sie zielgerichtet, wie Sie Ihre Daten gemäß den individuellen Anforderungen Ihres Unternehmens optimal verwalten können und unterstützen Sie bei der Auswahl und Implementierung der geeigneten Lösungen. Kontaktieren Sie uns jetzt für eine unverbindliche Anfrage

Kontaktformular

Sie interessieren sich für unser Smart Data Management Angebot? Kontaktieren Sie uns gerne über das Kontaktformular.