Künstliche Intelligenz - VR & AR: Weniger Fachkräfte, mehr Effizienz

KI ist gefährlich, eliminiert Arbeitsplätze und macht uns zum gläsernen Menschen – alles das sind Szenarien, die aktuell kursieren. Müssen wir Angst haben vor Künstlicher Intelligenz? Begleiten Sie uns auf einer Spurensuche.

„Roboter und KI werden die Menschen mittelfristig im Arbeitsleben komplett ersetzen!“ – so oder so ähnlich lauten Schlagzeilen zu Entwicklungen rund um Künstliche Intelligenz. Das rasante Vorantreiben von intelligenter Software ist mit großen Unsicherheiten und Ängsten verbunden. KI wird immer mehr als Bedrohung ausgemacht und dargestellt. Doch sind diese Ängste berechtigt und wie kann man ihnen produktiv begegnen?

Jetzt noch mehr über den Tech-Trend KI erfahren!

Sorgen und Maßnahmen: eine Übersicht

Geht es nach führenden Köpfen der weltweiten Technikbranche, gibt es dafür Berechtigung: Hört man auf die Unterstützer eines offenen Briefes, sollte ein sofortiges Moratorium zur weiteren Entwicklung von KI vereinbart werden und für zunächst sechs Monate bestehen. Nur so könnten unkalkulierbare Risiken durch allgemeine Künstliche Intelligenz gemildert werden. Mehr noch: Die Unterzeichner, zu denen Elon Musk, Steve Wozniak und etliche Professoren für KI zählen, sprechen für den Fall eines ungebremsten Weiterlaufens von einem möglichen „tiefgreifenden Wandel in der Geschichte des Lebens auf der Erde“. Als Beispiele werden die Arbeitswelt und der unregulierte Umgang mit Mitteln wir Propaganda oder Hasskommentaren genannt. Das Ziel wäre die Entwicklung eines klaren ethischen Rahmens, der in der KI-Entwicklung nicht überschritten werden dürfte. Zudem sollte eine Entwicklung nur dann okay sein, wenn die „Wirkung der Lösung positiv und die Risiken überschaubar“ sind. Als vergleichbare Fälle werden dir Reproduktion menschlichen Lebens in der Embryonalforschung oder das Klonen herangezogen. Problematisch hier: weltweit harmonisierte Regeln, die auch kontrolliert werden könnten.

Europa als Innovationstreiber in Gefahr?

Auch auf europäischer Ebene wird über Ländergrenzen hinweg an Regulierung gearbeitet: Der sogenannte „AI Act“ ist der Entwurf einer KI-Verordnung der EU, um Technologien und Entwicklungen rund um KI zu reglementieren. Der Grund: Die Risiken von Entwicklungen in diesem Bereich überstiegen den reinen Datenschutz. Daher seien Politik und Gesetzgebung in der Pflicht, zu agieren. Die Idee ist ein vierteiliges Kategoriensystem, in das Anwendungen entsprechend ihrer Risikobewertung eingeordnet werden müssten. Je größer das Risiko, desto strenger wären die Regularien. Wie groß das regulatorische Maß hier sein sollte, ist allerdings Streitpunkt unter den Mitgliedsstaaten. Punkte wie die Möglichkeit zur biometrischen Echtzeitüberwachung und damit verbundene datenschutzrechtliche Problematiken sorgen dafür, dass sich die verschiedenen Regierungen uneins sind. Die Argumentation der Gegner von zu strenger Reglementierung: Man dürfe als Technologiestandort nicht ausgebremst werden. Die „Zukunftsfähigkeit“ müsse gewährleistet werden, um künftigen Wohlstand zu sichern. Untersuchungen von Interessensvertretungen für mehr KI-Einsatz sind sich sicher, dass der AI Act zu risikofixiert und an verschiedenen Stellen noch zu unklar sei.

Der deutsche Weg: ein Transparenzregister

Auch hierzulande wird heiß über das Thema KI diskutiert: Die Berliner NGO „Algorithm Watch“ hat in einem Konzeptpapier die Einführung eines Transparenzregisters für KI-basierte Anwendungen gefordert. Das Augenmerk liegt hier auf der besonderen Verantwortung von Behörden für automatisierte Prozesse. Diese müssen laut den Verfassern „verantwortungsvoll, grundrechtskonform und gemeinwohlorientiert“ sein. Algorithmen haben das Problem, dass Dinge wie Geschlechterklischees oder ein Racial Bias, also eine Voreingenommenheit aufgrund von rassistischen oder stereotypischen Vorstellungen, durch die Ersteller mit im Code verankert werden können. Der Code spiegelt am Ende nur die politische Absicht des Erstellers wider. Darum sollen in besagtem Transparenzregister Parameter wie das Entscheidungsmodell der KI, Akteure, die an der Entwicklung beteiligt sind und die Methoden zur Datensicherheit hinterlegt und einsehbar gemacht werden. Eine „Taskforce KI-Kompetenz“, bestehend aus Expertinnen und Experten aus Bereichen wie KI und Antidiskriminierung oder unabhängigen Aufsichtsstellen von Dritten, könnte die Bundesregierung im Aufbau von Kompetenz für ein solches Register unterstützen. Auch der deutsche Ethikrat stellt fest: KI darf den Menschen nicht ersetzen! Die Regierungsseite hat bei diesem Thema bereits Offenheit bekundet, allerdings wurden noch keine konkreten Anstrengungen unternommen.

Anreize schaffen statt Verzicht

Allen Risiken und Vorurteilen zum Trotz, liegen im Thema KI viele Vorteile und Potentiale für die Zukunft. Es herrscht ein allgemeines Bewusstsein dafür, dass ein kompletter Verzicht auf KI und KI-basierte Anwendungen keine Option ist. Auch die Bundesregierung ist sich dessen sicher und hat Investitionen in KI sogar im Koalitionsvertrag verankert: „Wir werden Treiber eines starken Technologiestandorts, der auf europäischen Werten basiert […]. Investitionen in Künstliche Intelligenz (KI) […] und weitere Zukunftstechnologien stärken wir messbar und setzen Schwerpunkte.“ Auch im internationalen Kontext steht der Ausbau von KI ganz weit oben auf der Agenda: Die Defense Advanced Research Projects Agency (DARPA), eine Behörde des US-Verteidigungsministeriums, hat AI-Cyber-Challenge (AIxCC) angekündigt. Ziel ist es, Innovationen voranzutreiben, insbesondere im Bereich der Cybersicherheits-Tools. Kooperationen mit Tech-Giganten wie Google, Microsoft und OpenAI, aber auch Ratgebern für quelloffenen Code zeigen, wie präsent das Thema auf allen Ebenen ist. Mit einem Preisgeld von insgesamt bis zu sechs Millionen US-Dollar für den ersten Platz und zwei Millionen für eine Top-Fünf-Platzierung werden lukrative Anreize für Teams geschaffen, sich Ende diesen Jahres zu bewerben.

Auch die Big Player schalten sich ins Geschäft ein

Abgesehen von staatlichen Interessen an KI, sind in der technologischen Privatwirtschaft den Ambitionen keine Grenzen gesetzt. Google steckt seit geraumer Zeit große Mengen Geld in KI-Entwickler, Meta hat gar den Ausbau der eigenen Rechenzentren angehalten, um deren Architektur für optimierte KI-Anwendungen zu überdenken. Amazon will ebenfalls einen eigenen Konkurrenten zu ChatGPT von OpenAI entwickeln. Das Programm, das große Wellen geschlagen hat, ist nach wie vor führend in der breiten Wahrnehmung von KI-Anwendungen und hat bereits jetzt weltweite Veränderungen eingeleitet. Mega-Konzern Microsoft arbeitet eng mit OpenAI zusammen und plant, insgesamt 100 Milliarden US-Dollar in die Entwickler aus San Francisco in den nächsten zehn Jahren zu investieren. ChatGPT soll kontinuierlich weiterentwickelt werden, eine stetige Expansion wird voranschreiten – daran gibt es kaum Zweifel.

IT Trends 2023/2024 Whitepaper – Jetzt kostenlos lesen!

Microsoft und OpenAI: Zukunftsallianz?

Die Zusammenarbeit von Microsoft und OpenAI geht allerdings über reine finanzielle Mittel hinaus: OpenAI nutzt beispielsweise das Azure-Cloud-Computing-Netzwerk, um die generative Engine von ChatGPT zu betreiben. Andererseits basiert eine Reihe von Microsoft-Azure-Diensten auf Technologien des so schnell gewachsenen KI-Unternehmens. Das Team um CIO Sam Altman schafft zusätzlich immer mehr Möglichkeiten, die eigenen Dienste zu nutzen: Die Integration von ChatGPT und Whisper, einem Modell für Spracherkennung und Textumwandlung, in die Softwareprodukte Dritter ist beispielsweise durch eine API, die seit dem 01.03.23 existiert, deutlich einfacher geworden. Das KI-Programm soll zudem gerade im Bereich Datacenter immer präsenter werden. Ziele für zukünftige Entwicklungen sind in den Themenbereichen Kundensupport, Systemüberwachung, Ressourcenoptimierung, Cyber-Sicherheit und Systementwicklung angesiedelt.

Was ist nun aber mit Sicherheit?

KI-basierte Anwendungen können und dürfen nicht grundsätzlich verteufelt werden. In Bereichen wie der Medizin und der öffentlichen Verwaltung könnten sie unter anderem ergänzen und entlasten, so auch der deutsche Ethikrat. Trotzdem müssen gewisse Dinge beachtet werden, um KI so sicher wie möglich einzusetzen:

- Ein gutes und transparentes Training ist unabdingbar dafür, Anwendungen einschätzen und kontrollieren zu können. Nur mit dem Wissen darum, wie eine Anwendung entstanden ist und wie ihr Lernmodell aussieht, kann sichergestellt werden, dass sich Bias und menschlich fehlerhaft implementiere Logikkonstrukte nicht festigen.

- Die Implementierung der Anwendungen muss von Expertinnen und Experten im Bereich KI durchgeführt werden. Nur so können Sicherheitsstandards eingehalten werden.

- Über die Softwareebene hinaus müssen Kontrollmechanismen und robuste Sicherheitsmaßnahmen etabliert werden.

- Zudem müssen Richtlinien zur Anwendung von KI festgehalten und eingehalten werden. Diese variieren von Einsatzfall zu Einsatzfall. Nur wenn Risiken und Vorteile von Schutzmaßnahmen und der Einsatz der Anwendungen sorgfältig abgewägt werden, ist es möglich festzustellen, ob der Einsatz von KI gerechtfertigt werden kann.

KI und Sicherheit: Schon heute ein Faktor

Was viele nicht wissen: Schon heute sind KI-basierte Technologien und Algorithmen bereits wesentlicher Bestandteil von IT-Sicherheitsprodukten. Hersteller setzen KI in ihren Anwendungen ein, um die Lösungen noch sicherer und variabler zu machen. Sophos Intercept X ist ein prominentes Beispiel, in dem maschinelles Lernen und Deep Learning verwendet werden, um Angriffe zu erkennen und zu blockieren. Auch VMware Carbon Black oder Microsoft Defender for Endpoint sind KI-basierte Endpunkt-Sicherheitslösungen, die maschinelles Lernen und KI-Algorithmen nutzen, um Bedrohungen in Echtzeit zu erkennen und darauf zu reagieren. Ein anderes Beispiel ist VMware Workspace ONE Intelligence: Die Lösung, die ebenfalls KI und maschinelles Lernen verwendet, bewertet das Risikoprofil von Endbenutzern und überwacht dieses. Microsoft Defender for Office 365 nutzt KI, um E-Mail-Bedrohungen zu erkennen und blockieren, und Sophos Phish Threat kommt als Schulungslösung, mithilfe derer Mitarbeitende für Phishing-Angriffe sensibilisiert werden, zum Einsatz.

Jetzt kostenlose Beratung zu KI-basierten Lösungen anfragen!

Medialine: Ihr sicherer Partner für KI

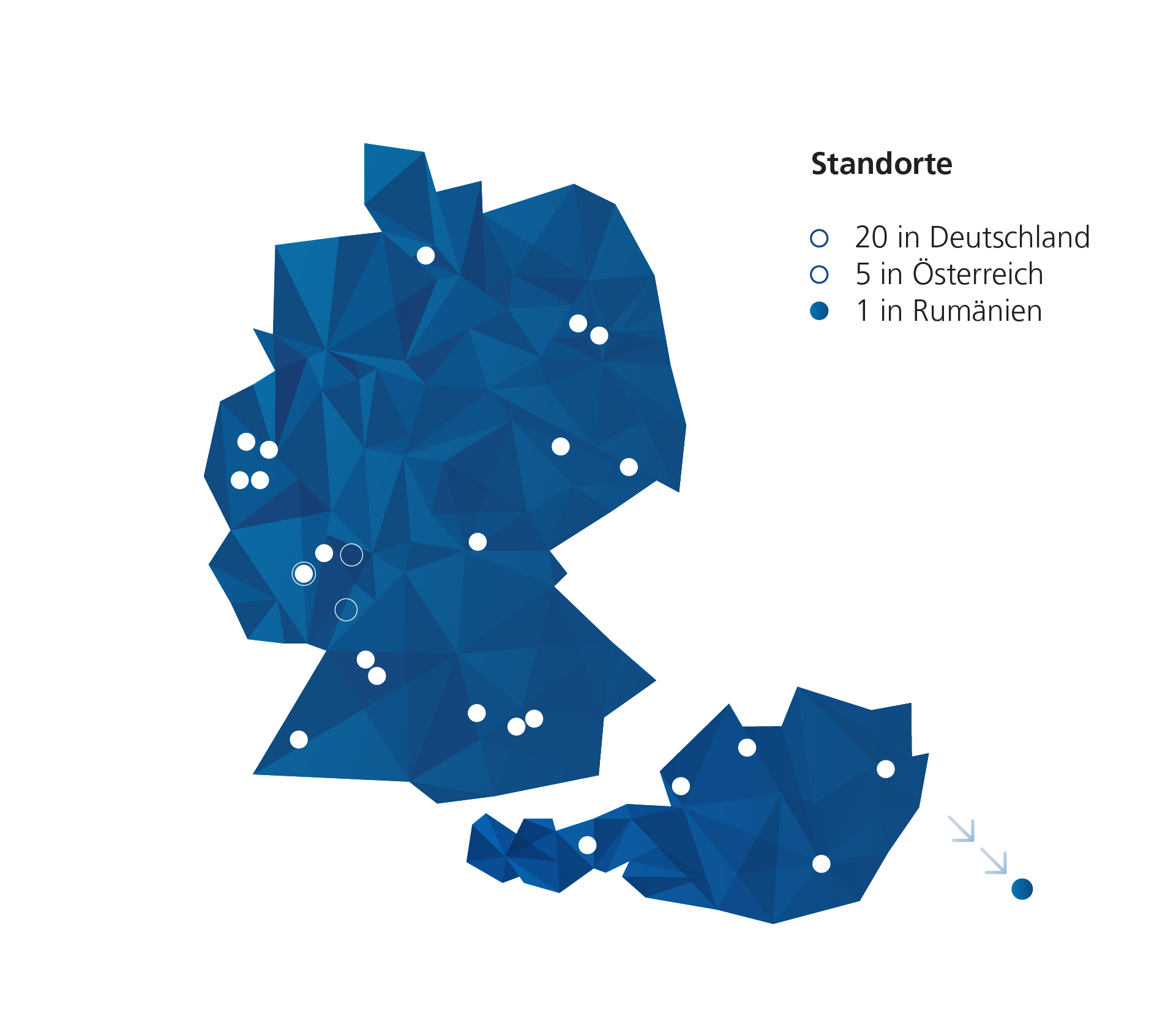

Wir bei Medialine haben langjährige Erfahrung im Bereich der KI-Anwendungen und unterstützen Sie gerne dabei, die richtige Anwendung für Ihren Bedarfsfall zu finden. Alle oben aufgeführten Lösungen sind mit uns realisierbar! Wir kümmern uns darum, dass Sie weder bei Sicherheitsthemen noch in Sachen Performance Einbußen hinnehmen müssen. Unsere Expertinnen und Experten sind für Sie da bei allen Fragen rund um Anwendungen, die für Sie mitdenken – jetzt und in Zukunft. KI ist eines der Themen der Zukunft – schon CEO Martin Hörhammer hat es als eines der Trendthemen schlechthin für die nächsten Jahre ausgemacht. Verpassen Sie nicht den Anschluss und rüsten Ihr Unternehmen bereits heute für die IT von Morgen. Kontaktieren Sie uns unter sales@medialine.ag und vereinbaren Sie ein unverbindliches Beratungsgespräch. Wir freuen uns auf Sie!